Trong kỷ nguyên bùng nổ của trí tuệ nhân tạo (AI), khả năng biến ý tưởng thành hiện thực ngày càng trở nên dễ dàng hơn bao giờ hết. Một trong những ứng dụng thú vị và mạnh mẽ nhất của AI tạo sinh chính là khả năng tạo video từ văn bản (Text-to-Video). Bạn chỉ cần mô tả ý tưởng, và AI sẽ “vẽ” nên những thước phim sống động. Hôm nay, chúng ta sẽ cùng khám phá cách thực hiện điều này bằng thư viện diffusers mạnh mẽ từ Hugging Face – một công cụ không thể bỏ qua cho các nhà phát triển và người đam mê AI.

Bài viết này sẽ là kim chỉ nam chi tiết, từ A-Z, giúp bạn làm chủ công nghệ Text-to-Video với Diffusers, ngay cả khi bạn mới bắt đầu.

Diffusers là gì? Tại sao chọn Diffusers cho hành trình Text-to-Video của bạn?

Diffusers là một thư viện Python mã nguồn mở được phát triển bởi Hugging Face. Nó cung cấp các công cụ và mô hình khuếch tán (diffusion models) tiên tiến nhất đã được huấn luyện sẵn để tạo ra hình ảnh, âm thanh và giờ đây là cả video.

Tại sao Diffusers là lựa chọn hàng đầu cho Text-to-Video?

- Mã nguồn mở và Miễn phí: Ai cũng có thể tiếp cận, sử dụng và đóng góp.

- Cộng đồng Lớn mạnh: Dễ dàng tìm thấy tài liệu, hướng dẫn và sự hỗ trợ từ cộng đồng người dùng và nhà phát triển toàn cầu.

- Đa dạng Mô hình: Tích hợp nhiều mô hình Text-to-Video tiên tiến như ModelScope, AnimateDiff, và liên tục cập nhật những công nghệ mới nhất.

- Linh hoạt và Dễ sử dụng: Cung cấp các DiffusionPipeline tiện lợi, giúp đơn giản hóa quá trình làm việc với các mô hình phức tạp.

- Tương thích cao: Hoạt động tốt với các thư viện phổ biến khác trong hệ sinh thái AI của Python như PyTorch.

Chuẩn bị “Bếp Núc”: Cài đặt và Thiết lập Môi trường

Trước khi bắt tay vào “nấu nướng”, chúng ta cần chuẩn bị đầy đủ “gia vị”.

Yêu cầu:

- Python (phiên bản 3.8 trở lên được khuyến nghị).

- pip (trình quản lý gói của Python).

Lệnh cài đặt các thư viện cần thiết: Mở terminal hoặc command prompt của bạn và chạy lệnh sau:

pip install diffusers transformers accelerate torch torchvision torchaudio- diffusers: Thư viện chính của chúng ta.

- transformers: Cần thiết cho việc xử lý văn bản và tải các thành phần của mô hình.

- accelerate: Giúp tối ưu hóa việc chạy mô hình trên các phần cứng khác nhau (CPU, GPU, multi-GPU).

- torch (PyTorch): Nền tảng deep learning mà hầu hết các mô hình trong diffusers sử dụng.

- torchvision, torchaudio: Hỗ trợ xử lý hình ảnh và âm thanh (nếu cần).

Nắm Vững Khái Niệm Cốt Lõi Trước Khi Bắt Đầu

Để hành trình suôn sẻ hơn, hãy cùng điểm qua một vài khái niệm quan trọng:

- Diffusion Models (Mô hình Khuếch tán): Đây là trái tim của công nghệ. Hiểu nôm na, các mô hình này học cách tạo ra dữ liệu (ví dụ: hình ảnh, video) bằng cách đảo ngược quá trình thêm nhiễu dần vào dữ liệu gốc. Chúng bắt đầu từ nhiễu ngẫu nhiên và dần dần “khử nhiễu” để tạo ra kết quả mong muốn dựa trên điều kiện đầu vào (ví dụ: prompt văn bản).

- Pipelines trong Diffusers: Đây là các lớp trừu tượng hóa cấp cao, đóng gói toàn bộ quy trình từ đầu vào (văn bản) đến đầu ra (video). Chúng giúp bạn dễ dàng tải và sử dụng các mô hình phức tạp chỉ với vài dòng code.

- Models (Mô hình): Là các mạng nơ-ron đã được huấn luyện, chứa đựng “trí tuệ” để thực hiện việc chuyển đổi từ văn bản sang video.

Hướng Dẫn Thực Hành: Biến Chữ Thành Phim với Diffusers

Giờ là lúc chúng ta cùng nhau “biến chữ thành phim”!

Bước 1: Quy trình chung để tạo video từ văn bản

Dù bạn sử dụng mô hình cụ thể nào, quy trình chung thường bao gồm các bước sau:

- Chọn Pipeline Text-to-Video: Lựa chọn một DiffusionPipeline phù hợp với mô hình bạn muốn.

- Tải Pipeline và Model: Sử dụng phương thức from_pretrained() để tải pipeline cùng với trọng số của mô hình từ Hugging Face Hub.

- Chuẩn bị Prompt: Viết một hoặc nhiều câu mô tả (prompt) chi tiết về nội dung video bạn muốn tạo.

- Chạy Pipeline: Gọi pipeline với prompt và các tham số tùy chỉnh khác.

- Xuất Video: Lưu các khung hình được tạo ra thành một file video.

Bước 2: Ví dụ cụ thể với ModelScope Text-to-Video

ModelScope Text-to-Video (ví dụ: damo-vilab/text-to-video-ms-1.7b) là một lựa chọn phổ biến để bắt đầu.

import torch

from diffusers import DiffusionPipeline, DPMSolverMultistepScheduler

from diffusers.utils import export_to_video

# 1. Tải pipeline và model

# Đảm bảo bạn có đủ VRAM (khoảng 10-12GB cho model này ở float16)

pipe = DiffusionPipeline.from_pretrained(

"damo-vilab/text-to-video-ms-1.7b",

torch_dtype=torch.float16,

variant="fp16" # Sử dụng variant fp16 để tiết kiệm bộ nhớ

)

# 2. Chọn scheduler phù hợp

pipe.scheduler = DPMSolverMultistepScheduler.from_config(pipe.scheduler.config)

# 3. (Tùy chọn) Tối ưu hóa nếu VRAM hạn chế

# Di chuyển mô hình sang CPU khi không dùng và chỉ tải lên GPU khi cần

pipe.enable_model_cpu_offload()

# pipe.enable_sequential_cpu_offload() # Một lựa chọn khác

# 4. Chuẩn bị prompt

prompt = "A panda eating bamboo on a rocking chair, beautiful sunset background"

# 5. Tạo video frames

# num_frames: số lượng khung hình mong muốn cho video

# num_inference_steps: số bước suy luận, càng cao chất lượng có thể tốt hơn nhưng tốn thời gian hơn

print("Bắt đầu tạo video...")

video_frames = pipe(prompt, num_inference_steps=25, num_frames=24).frames

print("Đã tạo xong các khung hình video!")

# 6. Xuất video

# fps: số khung hình trên giây

video_path = export_to_video(video_frames, output_video_path="./panda_rocking_chair.mp4", fps=8)

print(f"Video đã được lưu tại: {video_path}")Giải thích code:

- DiffusionPipeline.from_pretrained(…): Tải mô hình và pipeline. torch_dtype=torch.float16 và variant=”fp16″ giúp giảm yêu cầu VRAM.

- DPMSolverMultistepScheduler: Một scheduler hiệu quả thường được dùng cho các tác vụ tạo sinh.

- enable_model_cpu_offload(): Kỹ thuật hữu ích khi VRAM GPU của bạn không quá lớn.

- pipe(prompt, …): Gọi pipeline để thực hiện quá trình tạo video.

- export_to_video(…): Tiện ích của diffusers để ghép các khung hình thành file MP4.

Bước 3: Sáng tạo hơn với AnimateDiff và Stable Diffusion

AnimateDiff không phải là một mô hình text-to-video độc lập hoàn toàn. Nó là một “motion adapter” (bộ điều hợp chuyển động) được thiết kế để hoạt động cùng với các mô hình text-to-image phổ biến như Stable Diffusion. AnimateDiff giúp “thổi hồn” chuyển động vào chuỗi các hình ảnh được tạo bởi Stable Diffusion, từ đó tạo ra video.

import torch

from diffusers import AnimateDiffPipeline, MotionAdapter, EulerDiscreteScheduler

from diffusers.utils import export_to_gif # Hoặc export_to_video nếu bạn muốn file MP4

# 1. Tải motion adapter của AnimateDiff

adapter = MotionAdapter.from_pretrained("guoyww/animatediff-motion-adapter-v1-5-2", torch_dtype=torch.float16)

# 2. Tải một mô hình text-to-image (ví dụ: Stable Diffusion 1.5)

# Bạn có thể thay thế bằng các checkpoint Stable Diffusion khác mà bạn thích

model_id = "runwayml/stable-diffusion-v1-5"

pipe = AnimateDiffPipeline.from_pretrained(model_id, motion_adapter=adapter, torch_dtype=torch.float16)

pipe.scheduler = EulerDiscreteScheduler.from_config(pipe.scheduler.config, beta_schedule="linear", clip_sample=False)

# 3. (Tùy chọn) Tối ưu hóa VRAM

pipe.enable_model_cpu_offload()

# 4. Chuẩn bị prompt

prompt = "A corgi dog wearing a party hat, happily wagging its tail, birthday celebration"

# 5. Tạo video frames

print("Bắt đầu tạo animation với AnimateDiff...")

output = pipe(prompt=prompt, num_frames=16, guidance_scale=7.5, num_inference_steps=20)

frames = output.frames[0] # output.frames là một list chứa các batch frames, ta lấy batch đầu tiên

print("Đã tạo xong các khung hình!")

# 6. Xuất video/gif

# AnimateDiff thường được dùng để tạo các đoạn GIF ngắn, nhưng bạn vẫn có thể xuất ra MP4

gif_path = "./corgi_party.gif"

export_to_gif(frames, gif_path, fps=8)

print(f"Animation đã được lưu tại: {gif_path}")

# Để xuất ra MP4:

# from diffusers.utils import export_to_video

# video_path = export_to_video(frames, output_video_path="./corgi_party.mp4", fps=8)

# print(f"Video đã được lưu tại: {video_path}")Giải thích code:

- MotionAdapter.from_pretrained(…): Tải bộ điều hợp chuyển động của AnimateDiff.

- AnimateDiffPipeline.from_pretrained(model_id, motion_adapter=…): Kết hợp motion adapter với một mô hình Stable Diffusion.

- num_frames: Số lượng khung hình cho animation. AnimateDiff thường hiệu quả với số lượng khung hình vừa phải (ví dụ: 16-32).

Bí Quyết Vàng: Mẹo Tối Ưu Hóa và Những Lưu Ý Quan Trọng

Để tạo ra những video ấn tượng và tối ưu hóa quá trình làm việc:

- Sức mạnh của Prompt:

- Càng chi tiết, càng tốt: Mô tả rõ đối tượng, hành động, bối cảnh, phong cách nghệ thuật (ví dụ: “cinematic lighting”, “anime style”, “photorealistic”).

- Thử nghiệm: Đừng ngại thử nhiều prompt khác nhau để xem kết quả nào ưng ý nhất.

- Negative Prompts: Sử dụng negative_prompt=”your_negative_keywords” để loại bỏ các yếu tố không mong muốn (ví dụ: “blurry”, “low quality”, “watermark”, “text”).

- Thông số quan trọng:

- num_inference_steps: Số bước suy luận. Giá trị cao hơn (ví dụ: 25-50) có thể cho chất lượng tốt hơn nhưng tốn thời gian hơn.

- guidance_scale: Mức độ bám sát của video vào prompt. Giá trị cao hơn (ví dụ: 7-10) khiến video bám sát prompt hơn, nhưng có thể làm giảm tính đa dạng.

- num_frames: Số lượng khung hình của video.

- width, height: Kích thước (resolution) của video. Lưu ý kích thước lớn hơn sẽ yêu cầu nhiều VRAM hơn.

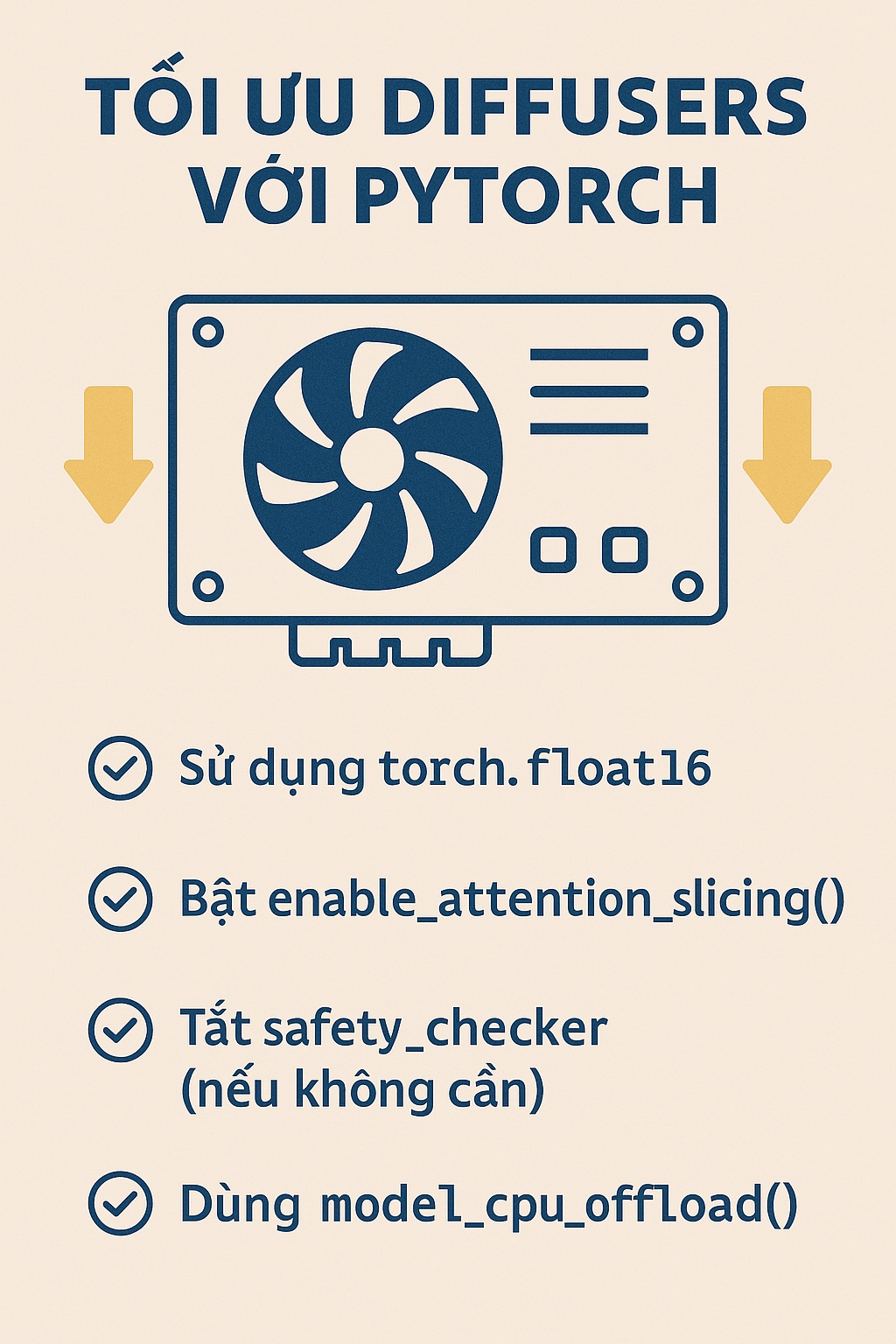

- Yêu cầu phần cứng (VRAM):

- Text-to-Video là một tác vụ nặng. GPU với VRAM lớn (tối thiểu 8GB, khuyến nghị 12GB trở lên cho các model chất lượng cao) là rất cần thiết.

- Sử dụng torch_dtype=torch.float16 (half-precision) và các kỹ thuật cpu_offload để giảm tải VRAM.

- Thời gian Render: Hãy kiên nhẫn! Quá trình tạo video có thể mất từ vài phút đến vài chục phút tùy thuộc vào độ dài, độ phức tạp và phần cứng của bạn.

- Bản quyền: Khi sử dụng hình ảnh hoặc phong cách từ các nghệ sĩ cụ thể trong prompt, hãy cân nhắc về vấn đề bản quyền và đạo đức.

Vượt Qua Thử Thách: Hạn Chế Hiện Tại và Tương Lai Của Text-to-Video

Công nghệ Text-to-Video đang phát triển vũ bão, nhưng vẫn còn một số hạn chế:

- Tính nhất quán theo thời gian (Temporal Coherence): Đôi khi video có thể bị “nhấp nháy” hoặc các đối tượng thay đổi bất thường giữa các khung hình.

- Hiểu biết ngữ cảnh phức tạp: Các mô hình có thể gặp khó khăn với các prompt quá phức tạp hoặc trừu tượng.

- Yêu cầu tài nguyên cao: Như đã đề cập, việc này đòi hỏi phần cứng mạnh.

Tuy nhiên, với tốc độ nghiên cứu hiện tại, những hạn chế này đang dần được khắc phục. Tương lai của AI tạo video từ văn bản hứa hẹn sẽ còn mang đến nhiều điều bất ngờ và thú vị hơn nữa.

Lời Kết

Việc tạo video từ văn bản bằng Diffusers của Hugging Face mở ra một chân trời sáng tạo vô tận. Từ việc tạo các clip ngắn cho mạng xã hội, minh họa ý tưởng, đến việc sản xuất nội dung video độc đáo, tất cả đều nằm trong tầm tay bạn.

Đừng ngần ngại thử nghiệm, khám phá các mô hình khác nhau, tinh chỉnh prompt và chia sẻ những tác phẩm tuyệt vời của bạn với cộng đồng! Hành trình sáng tạo với AI chỉ mới bắt đầu.

Chúc bạn có những trải nghiệm thú vị và thành công trên con đường chinh phục công nghệ Text-to-Video với diffusers! Nếu bạn có bất kỳ câu hỏi hay khám phá nào thú vị, đừng quên chia sẻ ở phần bình luận bên dưới nhé!